Aujourd’hui, les méthodes statistiques sont régulièrement utilisées et Robert Nadon s’est attaqué à un nouveau champ : la recherche pharmacologique.

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

Le chercheur se définit comme un méthodologiste, c’est-à-dire quelqu’un qui questionne les méthodes utilisées pour la recherche et cherche à les améliorer. " J’ai toujours voulu savoir comment nous savons ce que nous savons " raconte-t-il. C’est ce qui l’a amené aux statistiques : comme l’explique son collègue James Hanley, les chercheurs ont une grande confiance dans les chiffres, " ils traitent les nombres comme s’ils étaient absolus ". Mais pour cette équipe de l’Université McGill, les chiffres peuvent être biaisés pour de multiples raisons. Heureusement, les statistiques sont un outil efficace pour mieux les utiliser !

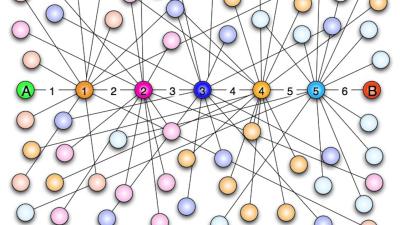

C’est dans l’une des premières étapes de la recherche de médicaments que les deux compères sont allés fourrer leur nez de statisticiens. Le " criblage à haut débit " vise à trouver des molécules prometteuses pour de nouveaux médicaments. Le principe est simple : on veut trouver un composé qui ait une réaction donnée, on teste 100 000 composés (rien que ça !), répartis en très petits échantillons sur des plaques de 100. Ensuite, on mesure à quel point chacun réagit et on garde les meilleurs pour les étudier plus en profondeur.

Dédoublement

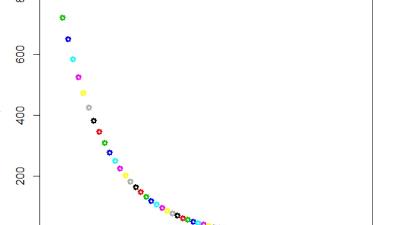

Le problème, c’est que, contrairement à ce que les chercheurs veulent bien croire, les résultats du test ne reflètent pas toujours le pouvoir intrinsèque des différents produits. " C’est un peu comme pour un examen, selon les sujets ou la forme des candidats, ils vont avoir des résultats qui ne correspondent pas forcément à leur valeur réelle. " Des composés peu efficaces ont pu, par hasard, obtenir de très bons résultats, alors qu’inversement, certains, très efficaces, auront eu de mauvais résultats et seront abandonnés. C'est ce qu'on appelle des faux positifs et des faux négatifs.

Première solution : " on étudie l’ensemble des données et on repère les variations régulières qui sont dues à des erreurs systématiques (par exemple, une pipette bouchée). Ensuite, il suffit de modifier les résultats pour compenser la variation " explique Nathalie Malo, étudiante au doctorat.

Pour les erreurs qui relèvent du pur hasard, l’équipe a aussi une solution en apparence anodine : tester les composés plusieurs fois. Tout simplement parce qu’une moyenne de plusieurs résultats donnera toujours une meilleure idée du potentiel d’un produit qu’un résultat unique. Cela relève du bon sens? Pas dans le criblage à haut débit. Les biologistes qui testent si un médicament augmente le risque de crise cardiaque ont toujours fait des expériences multiples, mais " dans le criblage à haut débit, c’est comme si on faisait l’expérience sur un seul patient, tout en faisant 100 000 expériences à la fois ! " s’amuse Robert Nadon.

Les biologistes rétorqueront peut-être qu'un humain et une molécule, ce n'est pas pareil: ignorer un effet secondaire et perdre l'ébauche d'un médicament, ce n'est pas comparable. Par ailleurs, qui dit dédoublement, dit coûts accrus. Ceci dit, le problème des coûts joue dans les deux sens: un bon composé que l'on a ignoré parce qu'on n'a pas répété l'expérience aurait pu être le médicament idéal et rapporter gros; et un mauvais composé inutilement pris en compte va faire l’objet de tests supplémentaires qui ne rapporteront rien. Bref, ce qu’on perd à faire des doubles, on pourrait bien l'économiser ailleurs…

Le seuil idéal

Reste à choisir la limite à partir de laquelle on juge les composés dignes de passer à l’étape supérieure. Si on choisit un seuil bas, on aura plus de faux positifs et inversement. Et ce que montrent les chercheurs, c’est qu’en combinant l’usage de doubles avec un seuil plus bas, on peut arriver à l'équilibre idéal: moins de bons composés qui passent inaperçus, sans augmenter le nombre de "mauvais".

Alors, quand verra-t-on ces conseils appliqués ? Pour Robert Nadon, les statistiques devraient être intégrées progressivement à la formation des biologistes. En attendant, des logiciels pourraient permettre aux biologistes actuels de mettre en œuvre ces conseils. " Je prêche un peu pour ma paroisse, mais je crois qu’il vaut mieux plutôt engager un statisticien, car les logiciels sont trop vite dépassés " objecte Nathalie Malo. Mais Robert Nadon insiste : " les scientifiques ne devraient pas se décharger sur une personne tierce. Cela fait partie de la responsabilité des chercheurs que de s’assurer de la solidité de leurs données. "