Un sujet bien conduit, mais un mauvais choix d’angle

Suite à cette étude, de nombreux articles ont été publiés sur ce dilemme : comment programmer la voiture autonome en vue de ces accidents exceptionnels ? Tous sont bien écrits, et reprennent les mêmes informations :

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

- La voiture à conduite autonome est positive dans l’ensemble : elle augmenterait la fluidité du trafic, améliorerait les performances du moteur, réduirait le nombre d’accidents sur les routes (90 % selon certaines projections), même si elle provoquerait de nouveaux rares accidents lorsque le programme de la voiture devra choisir entre deux situations menant chacune à un malheur ;

- Un nombre représentatif de sondés (75 %) répond que le programme doit chercher à minimiser l’accident, quitte à ce que cela « sacrifie » le propriétaire de la voiture ;

- Un nombre représentatif de sondés (70 %) répond qu’il n’achèterait pas une telle voiture à titre personnel ;

- La manière de programmer les algorithmes ne peut être laissée au choix des constructeurs par un vide juridique (sinon, cela ouvre la porte à des dérives comme l’option paramétrable décrite par cet article).

L’angle de ces articles est plus ou moins anxiogène et racoleur, mais il s’agit toujours du même angle, qui malgré une remise en contexte à un moment ou à un autre est monté en épingle au détriment d’une discussion d’ensemble. Il est normal qu’on observe une vague d’informations sur cet angle puisqu’il s’agit du sujet de la publication scientifique, mais pourquoi n’observe-t-on pas de telles vagues d’informations sur d’autres angles ? Pourquoi pas « Les voitures autonomes sauveront des vies, avec un point de détail important détaillé en fin du troisième paragraphe de l’article » ? La question de la moralité algorithmique doit être prise au sérieux, certes, mais doit-elle déborder de sa place de point technique et juridique important juste pour faire des articles aux titres accrocheurs ?

Utilitarisme ou déontologie ?

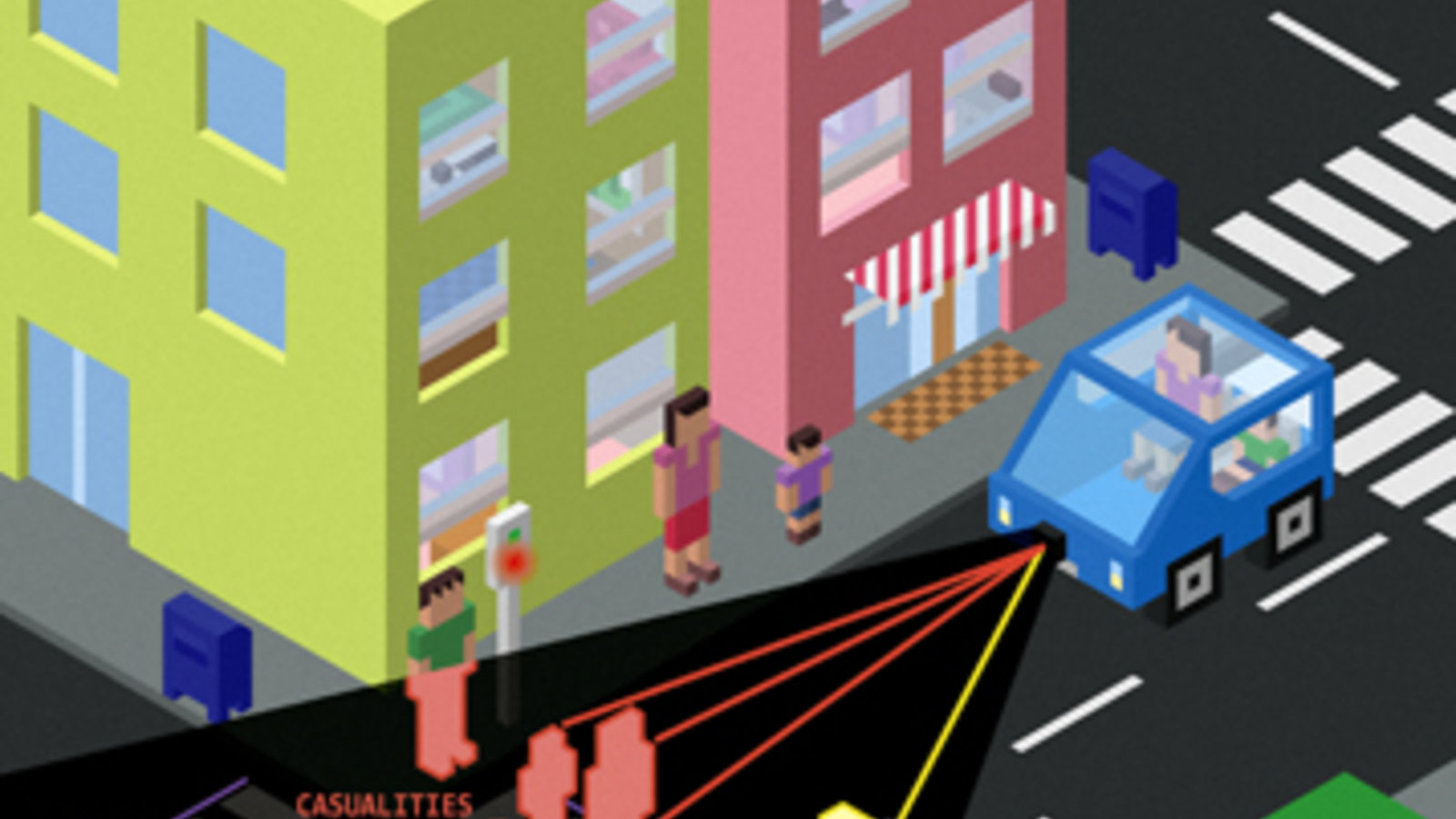

Puisqu’il le faut, concentrons-nous sur ce seul aspect : le dilemme en cas d’accident exceptionnel. Prenons un exemple classique, la voiture fonce vers un groupe de cinq piétons très proches au milieu de la route, elle a le choix entre freiner en continuant sa course et tuer les cinq piétons ou éviter les cinq piétons et tuer le conducteur en s’encastrant dans un mur. Face à un tel dilemme, un conducteur humain n’a pas le temps de se poser la question : il réagit et l'on déplore l’accident quel qu’il soit, sans pouvoir juger le « réflexe ». Avec un algorithme qui peut calculer et comparer les situations (en supposant que la connaissance de son environnement soit idéale), la question philosophique de la responsabilité se pose. Selon le point de vue utilitariste, il faut choisir la solution au résultat le « moins pire », peu importe l’intention (dans l’exemple, éviter les piétons). Selon le point de vue déontologique, il faut choisir l’intention la « moins pire », peu importe le résultat (dans l’exemple, freiner en continuant sa course). Si l'on multiplie les exemples (ne serait-ce qu’avec un piéton et cinq passagers), la logique utilitariste va répondre au cas par cas en attribuant une valeur aux personnes, la logique déontologique va refuser les dérives liées au résultat en restant sur une position d’intention comme l’appliquent les réflexes des conducteurs.

Si la loi exprime la morale utilitariste comme on a tendance à l’aimer, l’adoption de la technologie pourrait être ralentie, ce qui freinerait le développement de ses bénéfices. Si la loi exprime la morale déontologique, qui est difficile à accepter, les programmes se comporteront mieux que les humains en général, mais n’exploiteraient pas leur plein potentiel de programmes dans des situations exceptionnelles comme le voudrait la logique utilitariste. Vu la manière subjective dont j’ai formulé ces deux philosophies, vous pouvez comprendre à quel choix mes lectures m’ont mené et avoir les outils pour faire votre propre choix.

Pour formuler autrement mon point de vue, prenons une citation de l’article Les voitures autonomes devraient sacrifier leur conducteur pour sauver des passants, mais… : « C'est la signature classique d'un dilemme social dans lequel chacun a la tentation de la facilité plutôt que d'adopter un comportement positif pour le bien commun ». Le dilemme social est ici décrit d’un point de vue utilitariste (même s’il n’est pas présenté comme un point de vue). Cependant, du point de vue déontologique, ne serait-ce pas la description inverse ? Faire le choix de l’utilitarisme ne serait-il pas la tentation de la facilité, et accepter par déontologie de ne pas toujours pouvoir prendre la « bonne décision mathématique » ne serait-il pas un choix, certes frustrant, mais moral à considérer ?

Sources

Voici les articles que j’ai lus pour écrire ce billet, même si je suis conscient qu’il y en a d’autres. Le classement que j’ai fait est bien entendu subjectif : j’ai classé comme « mauvaises » les formulations qui jouent directement sur l’idée de « programmer la mort », puisque l’idée qui s’en dégage est dommageable pour de véritables réflexions sur le sujet.

Bonnes formulations du sujet

6 novembre 2013 : Voiture autonome : il ne reste plus qu’à améliorer le facteur humain ! À lire aussi pour son dernier paragraphe, Voiture autonome ou transports publics ?, qui remet en question le présupposé selon lequel la voiture autonome est le seul transport miracle de demain.

23 mai 2014 : Une voiture autonome qui vous veut du bien. Vraiment ? Bon dernier paragraphe sur utilitarisme et déontologie

26 octobre 2015 : Voiture sans conducteur : le CNRS étudie les choix « moraux » lors d’accidents mortels

28 octobre 2015 : Pourquoi les voitures sans conducteur devront être programmées pour tuer

24 juin 2016 : Sociologie : le dilemme de la voiture autonome inoffensive

24 juin 2016 : Voiture autonome : piéton ou conducteur, qui devra-t-elle sauver ?

25 juin 2016 : Le dilemme de la voiture autonome : qui sauver, le passager ou les piétons ?

26 juin 2016 : Sécurité : Les voitures autonomes doivent-elles se sacrifier en cas de danger ?

27 juin 2016 : Tuer le piéton ou le conducteur : Le dilemme insoluble de la voiture autonome

Mauvaises formulations du sujet

24 octobre 2015 :

Et si les voitures sans conducteur étaient programmées pour nous tuer ?

3 novembre 2015 : Les voitures autonomes vont être programmées pour tuer

23 juin 2016 : Prêts à circuler dans une voiture programmée pour nous tuer ?

24 juin 2016 : Votre voiture autonome devra-t-elle être programmée pour vous tuer ?

24 juin 2016 : Êtes-vous prêts à acheter une voiture qui choisira de vous tuer ? Le dilemme social des voitures autonomes

25 juin 2016 : Faut-il programmer votre voiture autonome pour vous sacrifier ?

25 juin 2016 : Voiture autonome : faut-il programmer votre mort ?

26 juin 2016 : Votre voiture autonome devra-t-elle être programmée pour vous tuer ?

26 juin 2016 : Voiture autonome : de qui programmer la mort ?

27 juin 2016 : Prêts à circuler dans une voiture programmée pour nous tuer ?

27 juin 2016 : Prêts à circuler dans une voiture programmée pour nous tuer ? (non, non, ce n'est pas un mauvais copier-coller)

En bonus : des articles sur l’accident d’une voiture semi-autonome le 7 mai 2016

1er juillet 2016 : Automobile : premier accident mortel pour la voiture autonome Tesla

2 juillet 2016 : L’accident mortel d’une Tesla influe sur l’avenir de la voiture autonome

4 juillet 2016 : Premier accident mortel avec une Tesla en pilote automatique

Dans l’article du 2 juillet, la phrase suivante m’a frappé : « Ce tout premier accident mortel d'une voiture en pilotage automatique fragilise l'argument des défenseurs de cette technologie ». À mon avis, de tels événements ne fragilisent que la portée des arguments, car étant humains nous sommes très sensibles aux exemples isolés, surtout impressionnants comme ici. Il s’agit donc bien d’une problématique de communication : trouver le juste milieu entre ne pas mentionner un point juridique important et faire monter en épingle un seul aspect d’une discussion scientifique au détriment de l’ensemble.