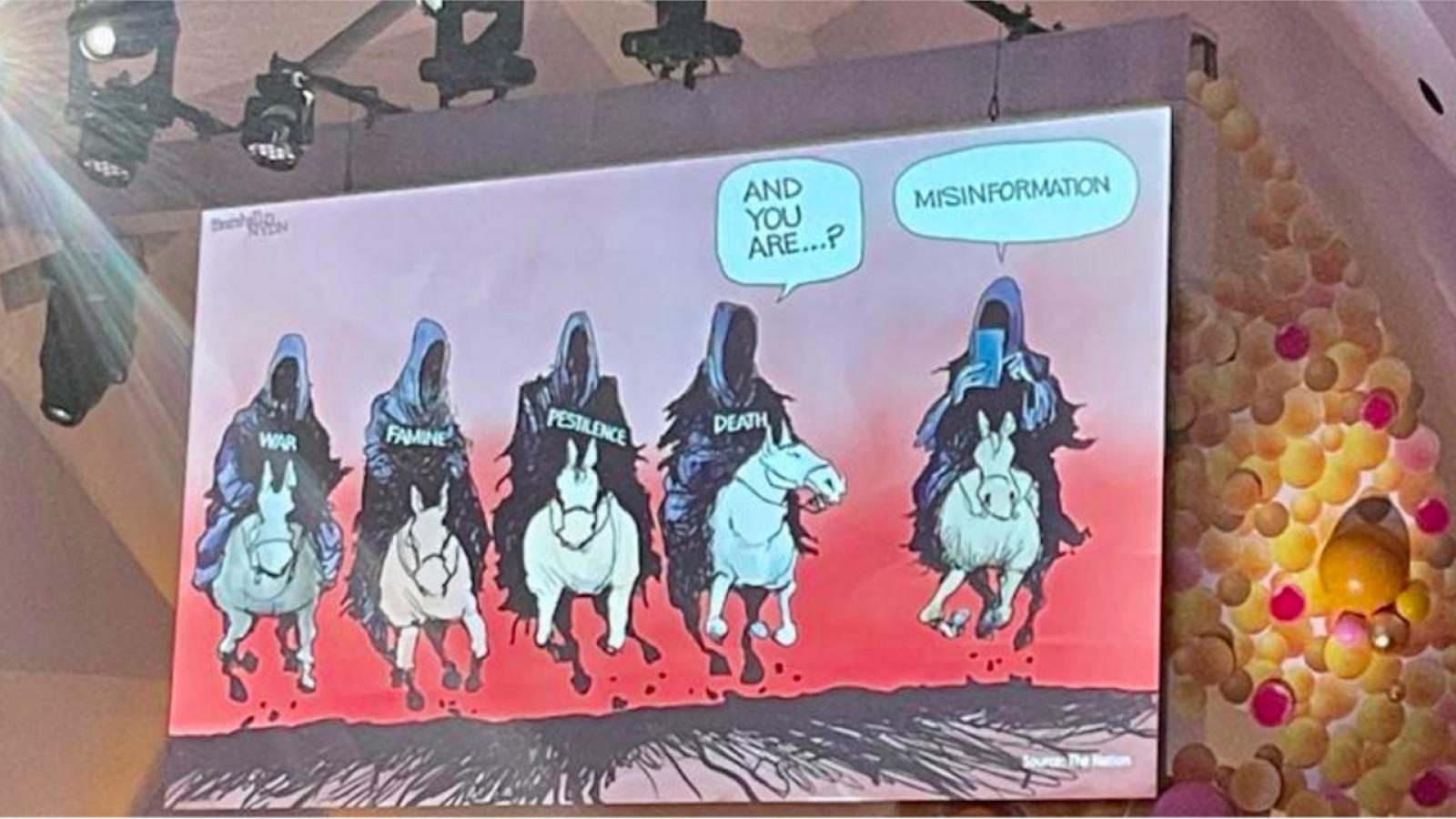

Vous êtes inquiets à cause de la désinformation en science? Il y a de quoi. Deux ingrédients font que le problème ne se résoudra pas sans un solide coup de barre de plusieurs acteurs de la société.

Ce texte fait partie de notre série sur Les coulisses de la désinformation en science

- D’un côté, le désir normal de tout être humain de s’intégrer dans un groupe —qui, dans nos sociétés plus polarisées, augmente le risque de croire à une fausseté, si on fait partie d’un groupe qui défend cette fausseté, sans se soucier des données scientifiques.

- De l’autre côté, les médias sociaux qui constituent la première source d’information d’un nombre croissant de gens, et qui sont un terreau fertile pour la dissémination de fausses nouvelles, mais surtout pour leur dissémination dans des groupes déjà prompts à y croire. Par exemple, données à l’appui, on a pu mesurer ces dernières années la force des « réseaux » antivaccins ou climatosceptiques.

S’ajoute désormais à cela, l’intelligence artificielle et sa capacité à générer, d’ici peu, une litanie sans fin de fausses nouvelles.

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

Le sujet était au coeur d’un colloque de trois jours, à Washington, organisé la semaine dernière par la Fondation Nobel et l’Académie nationale des sciences.

« Le vrai problème, ce ne sont pas les gens. C’est la structure de récompense des plateformes de médias sociaux », selon la psychologue comportementale Gizem Ceylan, de l’Université Yale. Elle fait référence aux mécanismes par lesquels, plus on clique sur des « j’aime » et des « partager », plus l’algorithme nous offre des messages, des photos ou des vidéos qui renforcent ce qu’on veut entendre. Ces retours nous font plaisir —ce sont nos récompenses— et nous incitent à aller en chercher encore plus.

Ceylan est l’une des auteures d’une étude qui, parue en janvier, conclut que c’est cette forme de reconnaissance ou de quête d’attention qui guide les comportements des usagers des médias sociaux, davantage que leurs motivations idéologiques.

Si cela s’avère juste, il y aurait donc là, en théorie, une piste de solution : « les médias sociaux, écrivaient Ceylan et ses collègues, pourraient être restructurés de manière à construire l’habitude de partager de l’information exacte ». Mais encore faudrait-il que les compagnies derrière ces plateformes soient convaincues qu’elles pourraient en tirer autant de revenus publicitaires qu’avec la situation actuelle...

L’une des participantes, la journaliste et auteure Maria Ressa, des Philippines, co-lauréate du Nobel de la paix 2021, est arrivée au colloque avec un manifeste qui en appelle entre autres à davantage de transparence des grandes compagnies dans leurs efforts allégués de modération et de lutte contre la désinformation.

Mais la communauté scientifique aura aussi un rôle à jouer, et pas uniquement en s’impliquant davantage dans l’espace public. À son insu, son propre mode de fonctionnement a contribué au problème: par exemple, les prépublications, ou études déposées sur un serveur avant d’avoir été révisées, sont devenues pendant la pandémie un aimant pour les amateurs de théories du complot qui peuvent y trouver des résultats non vérifiés, ou préliminaires, ou qui s’avéreront complètement faux lorsqu’ils auront été révisés. Considérant qu’un grand nombre de gens ne font pas la différence entre une étude pré-publiée et une étude tout court, ou entre une étude préliminaire et une solide, l’impact de cet accès plus large aux débats internes de la communauté scientifique n’a pas encore été évalué.

Ceci dit, là encore, il y a des pistes de solution. Une revue de la littérature scientifique a été présentée pendant le colloque par un nouveau regroupement de 200 chercheurs de 55 pays. Elle porte sur les méthodes expérimentées dans la dernière décennie pour lutter contre la désinformation, et elle arrive à la conclusion que les « étiquettes » apposées sur certains messages de certains médias sociaux (ce message-ci manque de contexte, ce message-là a été vérifié par une tierce partie qui l’a démontré faux, etc.) semblent avoir un impact positif —autrement dit, ces messages sont moins partagés. À travers les 600 études que ces chercheurs ont épluchées, il n’y a en revanche pas de consensus sur l’impact de la modération des contenus telle qu’elle est pratiquée —ou non— par les plateformes.

Le groupe en question, International Panel on the Information Environment (IPIE), lancé l’an dernier, dit vouloir s’inspirer du GIEC pour sa démarche: c’est-à-dire un groupe voué, non pas à mener ses propres recherches, mais voué à effectuer des synthèses des recherches déjà existantes —dans son cas, des recherches sur la désinformation ou « l’environnement de l’information ».

Dans son document fondateur, l’IPIE écrit: « Les biais algorithmiques, la manipulation et la désinformation, sont devenus une menace mondiale et existentielle, qui exacerbe des problèmes sociaux existants, dégrade la vie publique, nuit aux initiatives humanitaires et empêche des avancées face à d’autres sérieuses menaces. »

Les mensonges, a rappelé Maria Ressa, « se répandent six fois plus vite que les faits —des mensonges qui sont entrelacés avec de la colère et de la haine, nourrissant le pire de l’humanité. »

En vidéo sur le site de la Fondation Nobel: jour 1 du colloque « Truth, Trust and Hope », tenu à Washington du 24 au 26 mai 2023