Une intelligence artificielle pourra-t-elle un jour lire nos pensées? Chose certaine, les chercheurs d’une firme russe y travaillent: ils viennent de publier des résultats selon lesquels un algorithme pourrait décoder certaines des images vidéos que des gens sont en train de regarder. Du moins, une petite partie de ces images.

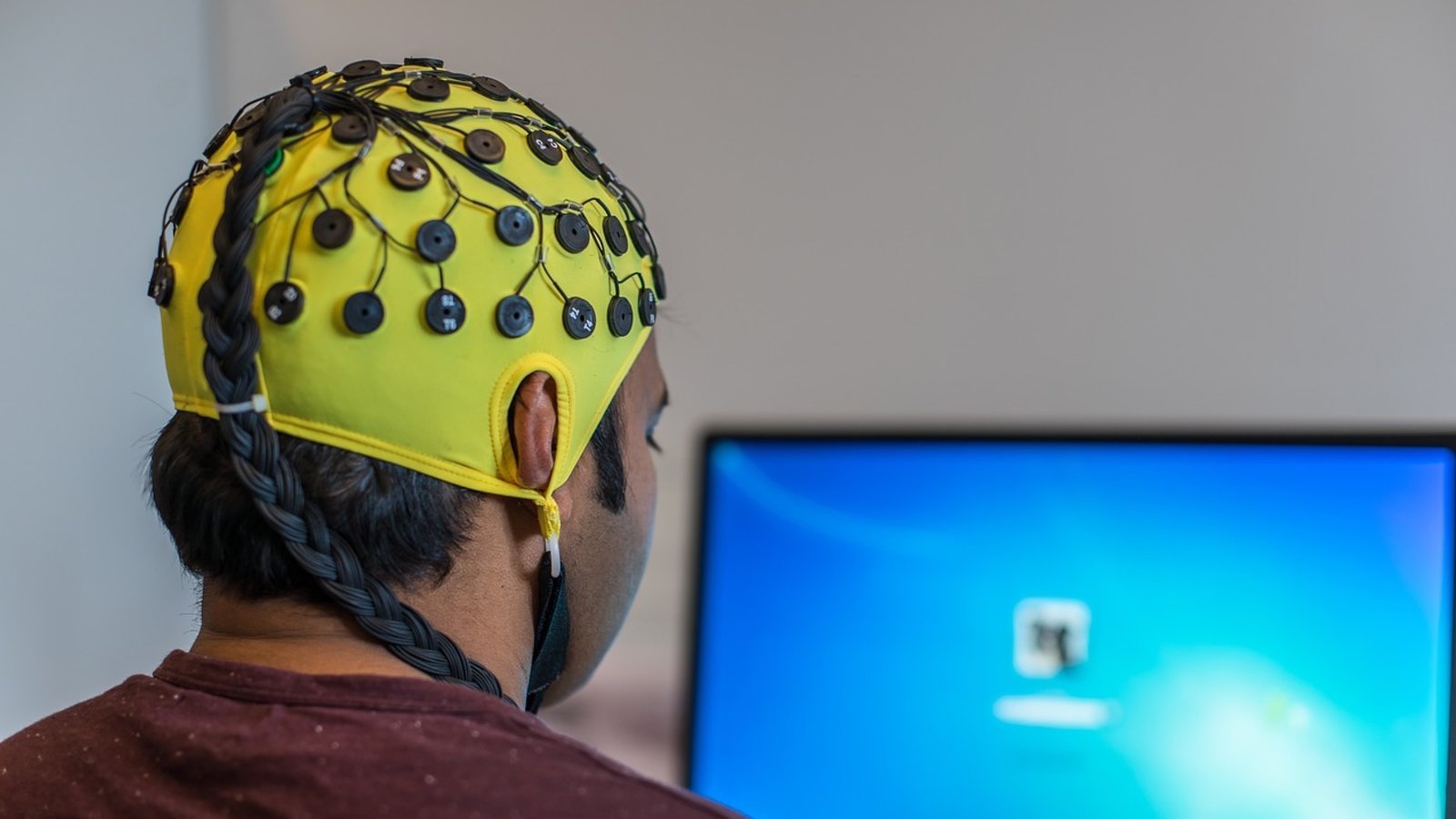

Les cobayes en question —17 en tout— étaient branchés à un électroencéphalogramme, et c’est l’enregistrement de leurs ondes cérébrales par cette machine que « l’autre machine » a tenté de traduire : l’intelligence artificielle s’est révélée capable (dans 210 essais sur 234) de distinguer les images par grandes catégories (figures géométriques, assemblages mécaniques complexes, cascades d’eau, sports extrêmes, visages humains avec différentes émotions) et ce, uniquement à partir des ondes cérébrales des gens. L’IA pouvait alors savoir si elle avait visé juste, et commencer à tenter de reproduire l’image. Mais c’est au-delà que ça se gâtait: l’IA pouvait reconnaître les couleurs primaires d’une image et les plus grandes formes, mais les nuances lui échappaient —avec pour résultat que, si sa reproduction d’une chute d’eau pouvait s’approcher de l’originale, sa reproduction d’un visage humain ressemblait plutôt à une peinture abstraite.

Il reste d’autant plus de chemin à faire que de futures recherches devront faire fi des grandes catégories pour rendre le travail de l’IA encore plus difficile. Mais dans leur texte, déposé sur le serveur de pré-publication Biorxiv, les chercheurs de la firme Neurobotics se disent confiants du potentiel pour « explorer l’efficacité d’une interface neuronale directe » (brain-computer interface) dans des circonstances plus près de la vie de tous les jours.