Avant d’aborder le sujet d’aujourd’hui, j’aimerais d’abord remercier toutes les personnes qui ont participé au cours Notre cerveau à tous les niveaux donné en collaboration avec l’UPop Montréal entre le 16 octobre 2019 et le 17 juin 2020. Les enregistrements vidéos des dix séances se retrouvent tous sur la chaîne YouTube du cours. Vous pouvez donc (re)visionner à loisir certaines séances, comme la cinquième par exemple, dont le sujet a un lien avec notre billet d’aujourd’hui. Intitulée « Cartographier des réseaux de milliards de neurones à l’échelle du cerveau entier », on y présentait différentes techniques d’imagerie cérébrale, dont l’une des plus utilisées, l’imagerie par résonance magnétique fonctionnelle (IRMf). Et l’on avait vu que non seulement les activations neuronales que détectent ces appareils sont faites de manière indirectes (en monitorant les débits sanguins vasculaires cérébraux), mais qu’elles pouvaient comporter de nombreux biais d’analyse. C’est ce que confirme de manière troublante une étude publiée le 20 mai dernier dans la revue Nature et intitulée « Variability in the analysis of a single neuroimaging dataset by many teams ».

Comme le résumait un article de la revue The Scientist qui commentait cette étude importante, on a demandé à 70 équipes de recherche indépendantes d’analyser le même jeu de données recueillies lors d’une expérience faite en IRMf. Résultat : aucune équipe n’a choisi la même approche pour analyser les données et leurs conclusions se sont avérées fort différentes !

L’étude menée par Tom Schonberg, Thomas Nichols et Russell Poldrack n’a pas eu de difficulté à recruter les 70 équipes. Le domaine de l’imagerie cérébrale, comme celui de la psychologie, fait face depuis de nombreuses années à une « crise » de reproductibilité des études. Le fait de pouvoir obtenir les mêmes résultats lorsqu’une autre équipe de rechercher applique le même protocole est, on le sait, le principe de base de la méthode scientifique. Or ce qu’on étudie en psychologie ou avec l’imagerie cérébrale est de plus en plus compliqué, de sorte que les données sont de moins en moins claires. Il faut alors appliquer toutes sortes de méthodes pour par exemple augmenter la clarté du signal par rapport au bruit de fond ou corriger les erreurs dues aux mouvements de la tête des sujets dans les scans. De plus, il faut faire des statistiques où intervient la notion de seuil à partir duquel des résultats vont être statistiquement significatif. Or de nombreuses méthodes statistiques existent et la plupart des 70 groupes de recherche, pour diverses raisons, n’ont pas choisi les mêmes méthodes.

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

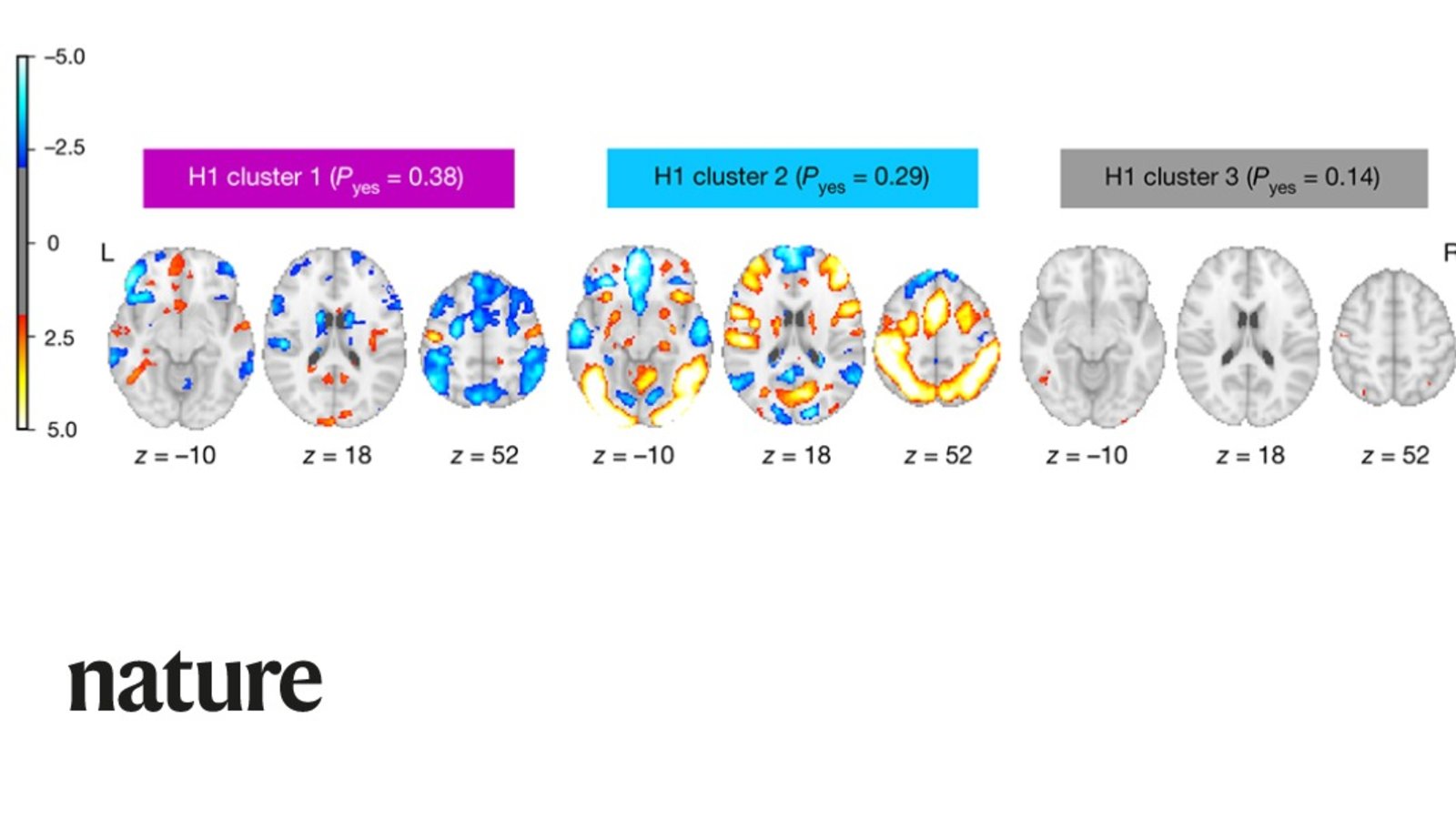

Tout cela a mené à des résultats assez décourageants en termes d’uniformité, de l’aveu même des auteurs de l’étude. La tâche à l’origine des données envoyées aux différents groupes était pourtant assez simple : les 108 sujets étendus dans l’appareil d’IRMf devaient décider ou non de parier une certaine somme d’argent. Les 70 équipes devaient vérifier neuf hypothèses concernant l’augmentation ou la diminution d’activité nerveuse dans différentes régions cérébrales quand le sujet prenait les décisions. Pour certaines hypothèses, il y avait un large consensus. Par exemple, celle voulant que l’activité dans le cortex préfrontal ventromédian diminue avec une perte d’argent a pu être confirmée par 84% des équipes. Et trois autres hypothèses ont été rejetées par plus de 90% des équipes.

Mais pour les cinq hypothèses restantes, les conclusions des équipes montraient beaucoup de variabilité. Pour les chercheurs dans ce domaine, cela va dans le sens de ce qu’ils craignaient : il y a simplement trop de degrés de liberté dans le choix des méthodes d’analyse à leur disposition. Et pour remédier à ce problème de taille, plusieurs changements s’imposent au sein de la communauté scientifique. Ainsi, les moindres détails des choix faits lors de l’analyse des données devraient être disponibles dans un souci de transparence totale. Les équipes de recherche devraient aussi préenregistrer leurs hypothèses, une pratique qui empêche ensuite de les adapter aux données (« SHARKing », en anglais). Elles devraient enfin toujours chercher à analyser leurs données avec de multiples méthodes d’analyse statistiques et différents paramètres. Seules de telles contraintes, importantes certes mais nécessaires pour éviter les dérives actuelles, permettront de départager les effets réels et robustes des expériences d’imagerie cérébrale de ceux qui sont créés de toute pièce par certaines méthodes d’analyse. Est-il besoin de rappeler ici la belle activation cérébrale qu’on avait obtenue lors d’une tâche de psychologie sociale dans le cerveau d’un… saumon mort ?