Les discours de peur sur les médias sociaux sont beaucoup moins étudiés par les chercheurs que les discours de haine. Se pourrait-il qu'ils soient encore plus dangereux ?

Ce texte fait partie de notre série sur Les coulisses de la désinformation en science

C’est ce que croient des chercheurs en analyses de données et en science de l’information pour qui « la nature non-toxique et argumentative » des discours de peur les rend « attrayants » à des usagers modérés —c’est-à-dire ceux qui n’auraient pas jugé acceptable un discours haineux. Ce qui, du coup, contribue à la « grande prévalence » de ces messages —ils sont davantage aimés, partagés et commentés. « De manière remarquable, leur prévalence est de loin supérieure à celle des messages haineux les plus connus. »

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

L’analyse est parue récemment dans la revue Proceedings of the National Academy of Sciences (PNAS).

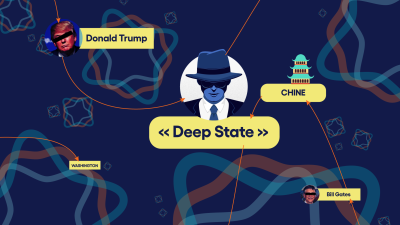

Ils s’appuient pour cela sur 400 000 messages définis comme étant « de peur » et 700 000 « de haine », récoltés sur la plateforme Gab: une plateforme réputée depuis 2017 pour ses usagers d’extrême-droite, racistes et antisémites, sympathique à toutes sortes de groupes complotistes et haineux. « Remarquablement, écrivent-ils, les usagers publiant un grand nombre de discours de peur acquièrent davantage d’abonnés et occupent des positions plus centrales que les usagers publiant un grand nombre de discours haineux. »

Ce n’est évidemment pas une découverte qu’on doit aux médias sociaux. Des historiens des quatre coins du monde peuvent citer toutes sortes d’exemples de chefs populistes pour qui la peur a été une arme indispensable pour leur montée en puissance —voire une arme pour inciter leurs adeptes à la violence.

La chroniqueuse Julia Angwin écrit à ce sujet dans le New York Times que même les pires génocidaires ont utilisé « la peur d’une menace imminente pour pousser des groupes à une violence préventive. Ceux qui commettent des actes violents n’ont pas besoin de haïr les gens qu’ils attaquent. Ils ont juste besoin d’avoir peur des conséquences, s’ils n’attaquent pas. »

Elle cite l’experte Susan Benesch, de l’Université Harvard, directrice du Dangerous Speech Project, qui rappelle à ce sujet le génocide du Rwanda. L’élément-clef de ce type de discours, c’est qu’il convainc les gens « de percevoir les autres membres d’un groupe comme une terrible menace. Ce qui rend la violence acceptable, nécessaire ou vertueuse. »

Les médias sociaux sont donc d’excellentes machines à relayer ce genre de discours de peur. D'autant plus qu'ils échappent souvent à la modération. Déjà, on savait que le discours de haine n’était pas toujours facile à détecter pour les algorithmes; mais le discours de peur l’est moins encore. Des humains peuvent faire la différence, mais encore faut-il que les plateformes soient prêtes à embaucher le personnel nécessaire pour reconnaître les indices, ce qui nécessite souvent une connaissance de la culture d'un pays.

Un chercheur américain en déradicalisation faisait la même proposition dans une recherche parue en 2020 : « aujourd’hui, le véritable défi pour des réseaux sociaux comme Facebook ou Twitter est de s’attaquer à un discours de haine qui se lit davantage comme un discours de peur et de politique identitaire et qui, pour cette raison, n’est pas repéré par les modérateurs ».

Comme piste de solution, la possibilité que chaque usager commence par développer sa capacité à identifier ce discours, serait un premier pas, reconnaissent les auteurs de la recherche parue dans PNAS. Savoir reconnaître les mots-clefs et surtout, les stratégies par lesquelles un habile manipulateur diffuse des peurs irrationnelles.

Une partie de la solution repose certainement entre les mains des plateformes elles-mêmes, ou entre les mains des gouvernements qui vont tôt ou tard les réglementer. Parce que ce sont leurs algorithmes qui favorisent cet « engagement » —plus un message est aimé et partagé, puis il « remonte » dans les fils des usagers. Et dans l’état actuel des choses, favoriser l’engagement, comme plusieurs recherches l’ont démontré ces dernières années, favorise les messages les plus choquants et les plus polarisants. Du moins, tant et aussi longtemps que les usagers eux-mêmes n’auront pas appris à prendre leurs distances de ces discours.