Ces dernières semaines, des anecdotes tragiques ont rappelé l’impact dangereux qu’avait eu l’IA sur la santé mentale d’individus fragiles. Une étude récente en psychologie s’est penchée sur pas moins de 17 cas de « troubles psychotiques » qui auraient été « alimentés par l’IA ».

À lire également

Il est certain que d’avoir à la portée de son clavier un chatbot qui s’adapte pour dire ce que l’humain veut entendre est un facteur déterminant, écrivent ces chercheurs britanniques et américains. Ces outils peuvent « imiter, valider ou amplifier les contenus délirants ou grandioses, particulièrement si les usagers sont déjà vulnérables aux psychoses ». Leur étude a été prépubliée sur le serveur PsyArXiv —c’est-à-dire qu’elle n’a pas encore été révisée par d’autres experts.

Élément important du problème : l’usager en oublie qu’il a devant lui un robot, et devient plutôt convaincu d’être en train de converser avec un individu doté d’une conscience —et qui plus est, un individu qui pense exactement comme lui, puisqu’il ne le contredit jamais et encourage même ses croyances. Ce qui accentue la « connexion », quitte à ce que cela devienne carrément une connexion amoureuse.

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

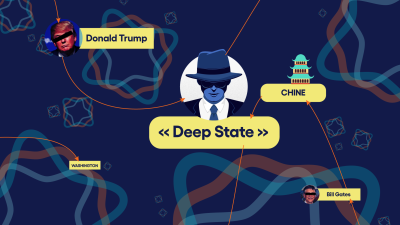

Des reportages récents ont pointé ce phénomène chez des croyants en des théories du complot, y compris certains qui ont entraîné leur propre chatbot pour valider leurs propres croyances.

Interrogé par le magazine de vulgarisation Scientific American, l’informaticienne Stevie Chancellor, de l’Université du Minnesota, qui n’a pas participé à la nouvelle étude, confirme qu’un comportement que les programmeurs tentent très fort d’intégrer dans les chatbots devient dans ce cas-ci un désavantage : leur capacité d’être agréables (ou du moins, d’en donner l’illusion). À l’évidence, un chatbot qui critiquerait ou contredirait l’humain ne serait pas aussi populaire. Cette illusion d’être agréable survient « parce que les modèles sont récompensés pour s’aligner avec les réponses qu’aiment les gens ».

Plus tôt cette année, Chancellor avait fait partie d’une équipe qui avait évalué les capacités des « larges modèles de langage » (la catégorie dont font partie les ChatGPT et autres Gemini), à agir comme « compagnons thérapeutiques en santé mentale ». Le résultat était inquiétant : les chatbots peuvent encourager des idées suicidaires, confirmer des hallucinations et renforcer le sentiment qu’a la personne d’être stigmatisée pour ses idées. « Je m’inquiète, disait Chancellor, de ce que les gens vont confondre le fait de se sentir bien » grâce à une apparence de progrès thérapeutique et une apparence de soutien fournie par l'IA.

La recherche est encore trop récente pour distinguer l’apport réel de l’IA dans des troubles de santé mentale : il est possible que ces outils ne fassent qu’encourager des pensées et des comportements qui étaient déjà présents chez ces individus. Mais même si ces outils ne font que contribuer à une perte de contrôle avec la réalité chez des individus qui étaient déjà à risque de perdre ce contrôle, ce ne serait pas un impact encourageant, conviennent les psychologues.

L’auteur principal de la nouvelle étude suggère aux proches des personnes affectées d’éviter la confrontation avec les croyances de ces personnes, mais de les encourager à passer moins de temps avec les outils d’IA.