En 2009, intrigué par la prolifération de fausses nouvelles autour du nouveau président Obama et de son projet d’assurance-maladie, un chercheur américain en sciences politiques avait décidé de mener une recherche sur les impacts de la désinformation sur l’opinion publique. Il ne se doutait pas qu’il deviendrait un pionnier d’un secteur de la recherche voué à gagner considérablement en importance.

À lire également

Quinze ans plus tard en effet, le nombre de recherches n’a pas seulement explosé, c’est un sujet qui a rassemblé des chercheurs de multiples disciplines, rapporte la revue américaine Science, qui consacre trois reportages à la question. Autant la désinformation politique avait, dans les années 2010, inspiré des psychologues, des sociologues, des politologues et des philosophes à lancer des recherches pour comprendre le phénomène et pour réfléchir à des pistes de solution, autant la COVID, dès le début de 2020, a obligé des chercheurs en santé publique à s’y intéresser aussi.

S’il y a une chose qui a changé dans l’intervalle, note le pionnier en question, Adam Berinsky, du Massachusetts Institute of Technology, c’est qu’on est moins « naïf » : ce ne sont plus juste quelques « histoires folles » (a few crazy stories) auxquelles on fait face, mais un véritable écosystème de la désinformation.

Abonnez-vous à notre infolettre!

Pour ne rien rater de l'actualité scientifique et tout savoir sur nos efforts pour lutter contre les fausses nouvelles et la désinformation!

Mais s’il y a une chose qui n’a pas changé, c’est qu’on n’a toujours pas mis le doigt sur les solutions qui permettraient de lutter le plus efficacement contre ceux qui contribuent à la dissémination de fausses informations qu’ils croient sincèrement être vraies.

Quand on observe les débats d’experts, on note toutefois que d’autres petites choses ont changé.

- Il y a par exemple près d’une décennie que les chercheurs préfèrent « désinformation » à « fausses nouvelles » (fake news) pour la simple raison que des informations « trompeuses » peuvent faire —il y a eu des études là-dessus— plus de dégâts que des fausses informations.

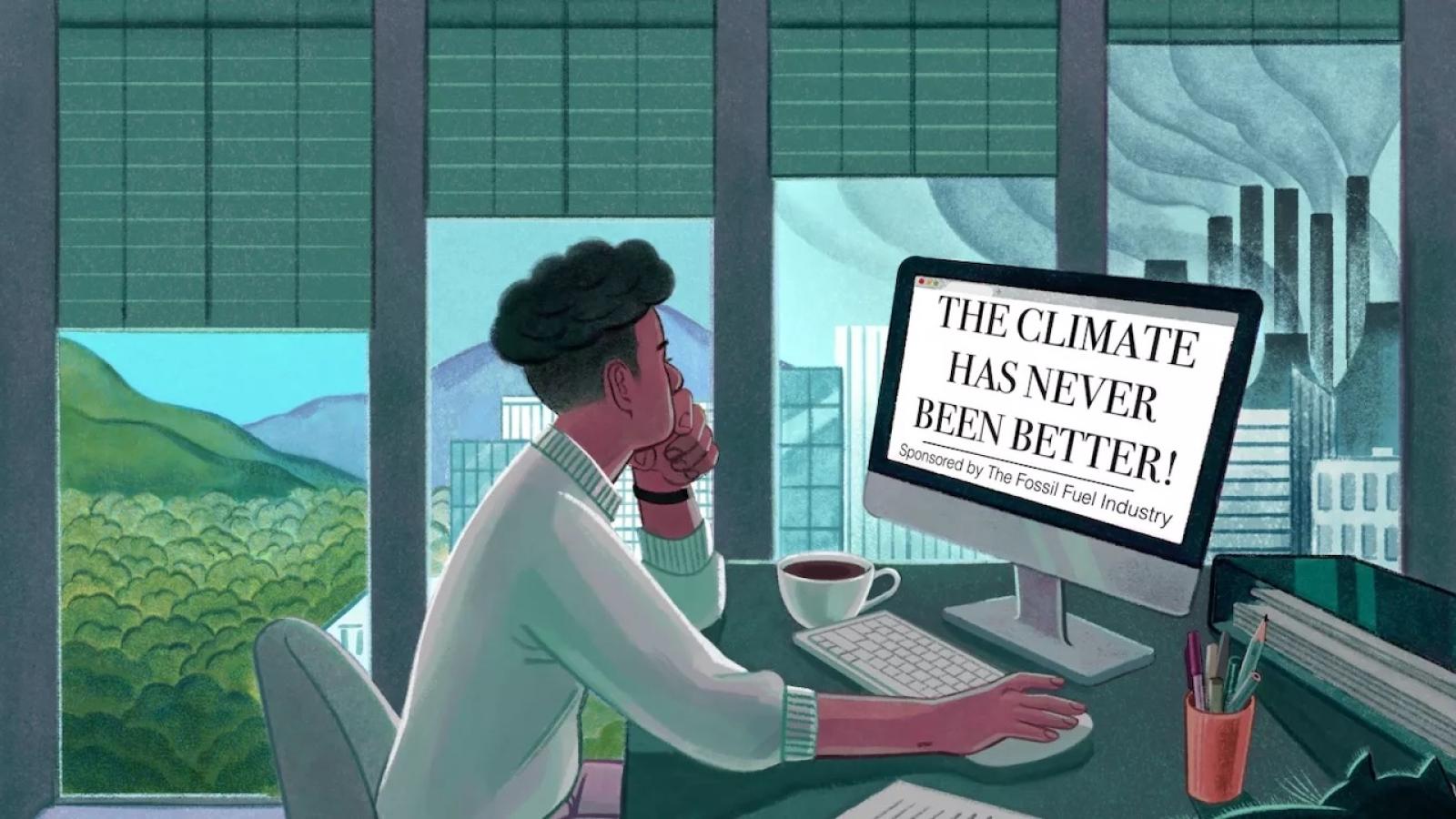

- Il y a également un bout de temps que l’on admet que la désinformation n’apparaît pas dans un vacuum: en arrière-plan, il peut y avoir un ordre du jour idéologique et bien financé. Ce n’est pas par hasard si, ces dernières années aux États-Unis, des groupes conservateurs se sont attaqués de façon virulente à des chercheurs qui étudiaient la désinformation politique: cette désinformation émanait beaucoup plus souvent de cercles conservateurs.

L’une des chercheuses en désinformation ainsi ciblée, Kate Starbird, de l’Université du Wisconsin, soupçonne qu’une raison de ces attaques et de ce harcèlement en ligne, n’est pas juste que son équipe étudiait la désinformation, « mais qu’elle la combattait. « Nous tentions de faire une différence face à un problème concret en temps réel », dit-elle.

Mais parmi les choses qui n’ont pas changé, et qui sont devenues des problèmes de plus en plus épineux avec les années, il y a l’opacité des plateformes de réseaux sociaux. L’algorithme, ce code informatique qui détermine quelle photo ou quelle vidéo sera privilégiée pour tel et tel type d’usager, est un secret d’entreprise. Et si on a pu ces dernières années, grâce à des chercheurs et des journalistes, déduire certaines des choses que l’algorithme privilégie —ce qui provoque une émotion et non une réflexion— il n’existe ni organisme de réglementation, ni observateur indépendant, qui puisse jeter un oeil sur ces lignes de code et assurer qu’elles n’ont pas des impacts nocifs sur la société, la démocratie ou la santé publique.

La seule exception était Twitter: longtemps, les chercheurs avaient accès à une partie de sa base de données, ce qui a permis de produire beaucoup d’études sur les comportements des usagers de Twitter et la façon dont des informations, vraies et fausses, se propagent. En mars 2023 toutefois, peu de temps après son acquisition par Elon Musk, la compagnie mettait fin à la gratuité de ce service.

C’est dans ce contexte qu’une nouvelle législation européenne pourrait peut-être changer des choses. Le Règlement sur les services numériques (Digital Services Act), entré en vigueur en novembre 2022, oblige les plateformes à fournir un accès aux chercheurs pour certains projets. L’impact que ça aura est observé attentivement par des chercheurs des autres régions du monde, qui ne manquent pas d’idées pour tenter de mesurer les impacts de la désinformation et les retombées des pistes des solution esquissées ici et là.